Un Glossario sull’Emotion AI: Capire i termini e concetti chiave

L’Emotion AI è una tecnologia relativamente nuova che sta guadagnando terreno in diversi casi d’uso, dal portare avanti ricerche di mercato a potenziare robot empatici. Ma cos’è esattamente l’Emotion AI, quali sono i termini e i concetti chiave e in che modo avrà un impatto positivo per la società?

Sommario

Cos’è l’Emotion AI?

L’Emotion AI o Affective Computing si può definire come una tecnologia volta a creare un insieme di sistemi in grado di riconoscere, interpretare e, in alcuni casi, rispondere alle emozioni umane attraverso l’utilizzo di algoritmi di machine learning. In particolare, l’affective computing è un tipo di intelligenza artificiale che si occupa dell’analisi degli stati affettivi umani.

Gli strumenti di Emotion AI oggi utilizzano diversi segnali umani per codificare gli stati affettivi:

- Prosodica: la “musica del linguaggio” che ci aiuta a capire il significato dal modo in cui le parole vengono pronunciate (ad esempio, terminare una frase con un tono acuto potrebbe suonare come una domanda)

- Postura: il modo in cui il nostro corpo si forma e si muove nel momento in cui reagisce a determinate situazioni (ad esempio, potremmo piegare le spalle quando ci sentiamo insicuri)

- Espressioni facciali: il modo in cui i nostri muscoli facciali si formano e si muovono quando reagiamo a certi stimoli (ad esempio, gli angoli delle nostre labbra possono curvarsi in un sorriso quando sentiamo ridere un bambino)

L’origine dell’Emotion AI

Il campo dell’Emotion AI è relativamente nuovo, ma lo studio delle emozioni esiste da tempo, grazie ad alcuni pionieri nel campo della psicologia. Ecco alcuni dei tanti:

Charles Darwin

Nel 1872, Charles Darwin pubblicò una teoria che sosteneva che (Scientific American) “… tutti gli esseri umani, e anche altri animali, mostrano emozioni attraverso comportamenti notevolmente simili”. Darwin ha condotto un piccolo esperimento per testarne il riconoscimento umano, che è ancora usato oggi nei moderni esperimenti di psicologia.

Paul Ekman

Paul Ekman ha contribuito a lungo nel campo delle emozioni. Nel 1978, Ekman, insieme al collega psicologo e ricercatore Wally Friesen, sviluppò il Facial Action Coding System (FACS), un sistema completo di misurazione facciale che chiunque, anche gli scienziati, poteva usare per comprendere le espressioni facciali. Ekman e Friesen hanno creato una classificazione delle action unit, il movimento di un muscolo facciale o di gruppi muscolari che configurano l’espressione di un’emozione, che alimentano il sistema FACS. Ekman ha scoperto sette emozioni primarie facilmente riconoscibili dalle espressioni facciali: gioia, tristezza, paura, disgusto, sorpresa, rabbia e disprezzo (gli esperti discutono se si tratti di un’emozione distinta).

Ekman in seguito scrisse un articolo (1997), “The Universal Facial Expressions of Emotions”, in cui trovò: “… forti prove dell’universalità di alcune espressioni facciali rispetto all’emozione e del motivo per cui le espressioni possono apparire in modo diverso nelle diverse culture”. Il lavoro di Ekman fornisce una base per molti strumenti di Emotion AI poiché il suo obiettivo era identificare le emozioni primarie facilmente riconoscibili dalle espressioni facciali e quindi misurabili.

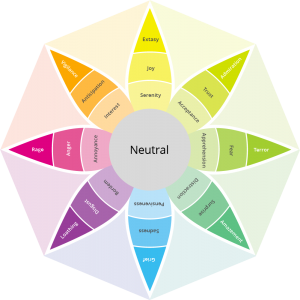

Robert Plutchik

Nel 1980, il professore universitario Robert Plutchik ha introdotto la “Ruota delle emozioni” per aiutare gli altri a comprendere i diversi tipi di possibili emozioni e livelli di intensità. La ricerca di Plutchik ha trovato oltre 30.000 emozioni, ma è stata ristretta a otto emozioni primarie in coppie polari opposte (Toolshero.com):

- Gioia vs. Tristezza

- Fiducia vs. Disgusto

- Paura vs. Rabbia

- Anticipazione vs. Sorpresa

Oltre alla “Ruota delle emozioni”, Plutchik ha scritto “Una teoria psicoevolutiva delle emozioni”, che descrive in dettaglio le origini evolutive delle emozioni, contribuendo a fornire un quadro per unificare diverse prospettive. La teoria di Plutchik fornisce diverse caratteristiche importanti, incluse queste poche (Plutchik tramite ScienceDirect.com):

- Un’ampia base evolutiva per concettualizzare il dominio delle emozioni come si vede negli animali e negli umani

- Un modello strutturale per le interrelazioni tra le emozioni

- Relazioni teoriche ed empiriche tra una serie di domini derivati inclusi i tratti della personalità, le diagnosi e le difese dell’Io

- Una motivazione teorica per la costruzione di test e scale per la misurazione delle dimensioni chiave all’interno di questi vari domini

>> POST ATTINENTI SUL BLOG : COME L’EMOZIONE PUÒ GUIDARE IL SUCCESSO DELLE TUE CAMPAGNE

Donald E. Brown

Nel 1990, il dottor Brown ha scritto un libro intitolato Human Universals incentrato sullo sfidare un argomento antropologico comune: se gli esseri umani di diversi segmenti demografici condividono tratti comportamentali universali. Il dottor Brown ha condotto sei casi di studio, uno dei quali focalizzato sulle espressioni facciali delle emozioni. Il dottor Brown ha scoperto che gli esseri umani condividevano una serie di espressioni di base, seguendo diversi studi con soggetti di culture diverse.

Emotiva

Nel 2017 nasce Emotiva con lo scopo di sviluppare algoritmi di computer vision e machine learning per analizzare le risposte emotive delle persone in tempo reale, misurando le micro espressioni facciali attraverso una normale webcam, per raccogliere dati utili alla comprensione dei comportamenti umani.

Il lavoro di Emotiva ha spinto i casi d’uso dell’Emotion AI a nuove applicazioni, dalla conduzione di ricerche di mercato alla creazione di un cervello emotivo per la robotica sociale e alla misurazione del coinvolgimento emotivo dell’arte attraverso una nuova tecnica di misurazione chiamata Indice di Stendhal.

Le parole chiave e i concetti relativi all’Emotion AI

L’Emotion AI coinvolge diversi termini e concetti chiave:

- Emozioni

- Riconoscimento delle emozioni

- Sentiment analysis

- Generazione delle emozioni

- Affective computing

- Interazione uomo-macchina

- Riconoscimento delle espressioni facciali

- Natural language processing

- Facial Coding

Emozioni

Sappiamo tutti come si provano delle emozioni, ma scientificamente le emozioni sono “una complessa miscela di azioni, espressioni e cambiamenti interni al corpo che si verificano in risposta al significato che diamo al nostro ambiente”, come ha scritto Carolyn MacCann, Ph.D.

Leggi di più su come le emozioni sono fondamentali per l’Emotion AI.

Riconoscimento delle emozioni

Anche gli esseri umani possono avere difficoltà a riconoscere certe emozioni. Il riconoscimento delle emozioni si riferisce all’utilizzo della tecnologia, in particolare degli algoritmi di machine learning e deep learning, per identificare le emozioni di una persona misurando le espressioni facciali, i movimenti del corpo o i segnali vocali. Gli strumenti di Emotion AI calcolano la risposta emotiva con quattro elementi principali: la geometria del volto, le caratteristiche di aspetto, l’attivazione delle Action unit e la correlazione tra di esse.

Leggi di più su come il riconoscimento delle emozioni contribuisce all’Emotion AI.

Sentiment analysis

Alcune persone esprimono meglio le proprie emozioni per iscritto. La sentiment analysis esamina il testo scritto per determinare il tono emotivo. Diverse aziende lo utilizzano per il monitoraggio dei social media o per valutare il feedback dei clienti.

Scopri di più su come la sentiment analysis contribuisce all’AI emozionale.

Generazione delle emozioni

Come definito da IGI-Global, è il “…processo di generazione di emozioni basate su stimoli esterni percepiti” per replicare il più possibile il comportamento umano. Con l’obiettivo di creare una sensazione artificiale attraverso l’elaborazione del linguaggio naturale, l’animazione facciale o altre tecniche.

Leggi di più su come la generazione delle emozioni contribuisce all’Emotion AI.

Affective computing

Come accennato in precedenza, l’affective computing coinvolge i sistemi e i dispositivi per rilevare, analizzare e rispondere alle emozioni umane in modo naturale. L’informatica affettiva combina diverse discipline: psicologia, ingegneria e informatica, per alimentare il cervello dell’Emotion AI.

Leggi di più su come l’affective computing contribuisce all’Emotion AI.

Interazione uomo-macchina

L’interazione uomo-macchina si concentra sulla progettazione, la valutazione e l’implementazione di sistemi informatici interattivi. L’Emotion AI ha il potenziale per migliorare notevolmente l’HCI (Human Computer Interaction) rendendo le interazioni con i computer più naturali e intuitive e consentendo alla macchine di rispondere allo stato emotivo di un utente in modo più significativo.

Leggi di più su come l’interazione uomo-macchina contribuisce all’Emotion AI.

Riconoscimento delle espressioni facciali

Nel contesto dell’intelligenza artificiale delle emozioni, il riconoscimento delle espressioni facciali utilizza algoritmi di machine e deep learning addestrati su grandi dataset di immagini etichettate, e webcam standard che rilevano sottili cambiamenti nei muscoli facciali, per identificare e classificare le espressioni facciali.

Leggi di più su come il riconoscimento dell’espressione facciale contribuisce all’Emotion AI.

Natural language processing

IBM definisce l’elaborazione del linguaggio naturale come la costruzione di “…macchine che comprendono e rispondono al testo o ai dati vocali e rispondono con un proprio testo o discorso, più o meno allo stesso modo degli umani”. L’Emotion AI utilizza l’elaborazione del linguaggio naturale per produrre e interpretare i dati di testo o vocali.

Leggi di più su come l’elaborazione del linguaggio naturale contribuisce all’Emotion AI.

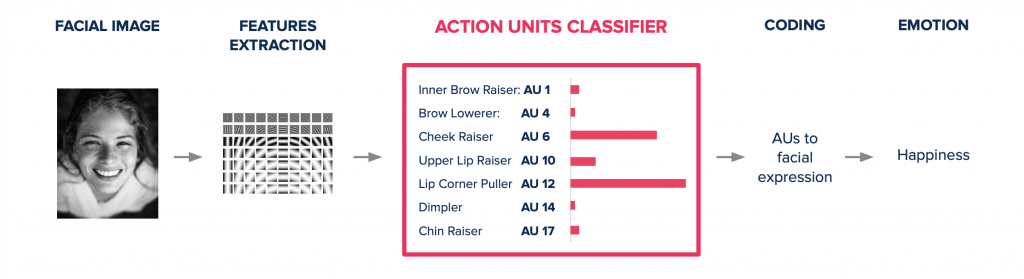

Facial Coding

Il sistema FACS (Facial Action Coding System) si usa attribuendo una combinazione di codici corrispondenti a determinati micro-movimenti facciali (Action Units) effettuati dal soggetto. È, inoltre, possibile identificare un’intensità del movimento e la combinazione di questi movimenti può portare a una successiva decodifica ovvero a una “traduzione” del codice in un significato prevalentemente emotivo.

Leggi di più su come il Facial Coding è importante in ambito marketing.

Come funziona l’Emotion AI

Ora che abbiamo una buona comprensione delle origini e dei termini chiave dell’Emotion AI, approfondiamo l’argomento su come funziona l’Emotion AI. L’Emotion AI, come dimostrato sopra, coinvolge diversi modi per identificare e classificare le emozioni, ma la computer vision è la tecnologia che viene maggiormente utilizzata per catturare le risposte emotive. Nel contesto dell’Emotion AI la computer vision si serve di normali webcam per identificare e misurare le micro espressioni facciali e codificare le risposte emotive attraverso la classificazione delle action unit.

Che cosa sono le Action Unit

Le Action Unit sono state classificate da Ekman all’interno del sistema FACS, e rappresentano i muscoli facciali o le combinazioni degli stessi che concorrono alla formazione di un’espressione di un’emozione. Il sistema FACS comprende 40 unità d’azione e centinaia di combinazioni, fornendo una ricca documentazione per supportare il rilevamento nell’ambito dell’Emotion AI.

Misurare le Action Unit

Il processo di rilevamento delle action unit attraverso la tecnologia di Emotiva funziona così:

- Si utilizza una normale webcam che cattura le reazioni delle persone (espressioni facciali, movimenti della testa a determinati stimoli, senza alcuna ulteriore configurazione.

- Il software Emotion AI elabora l’immagine per estrarre le prime feature, geometria del volto e di aspetto.

- Lo strumento di classificazione delle action unit individua ogni singola attivazione ed intensità muscolare.

- Al termine del processo di analisi, l’algoritmo mostra le espressioni delle emozioni individuate in base a quattro livelli di stati emotivi (primario, secondario, composto e di stato) attraverso la correlazione delle action unit attive.

Casi d’uso dell’Emotion AI

L’Emotion AI viene sfruttata in diversi settori per la sua capacità di fornire un livello di empatia nella ricerca e nell’analisi. Diventa ancora più potente se combinata con la misurazione dell’attenzione, che identifica il livello e la durata dell’attenzione. Questo approccio avanzato consente un maggiore potere decisionale.

Ecco alcuni casi d’uso dell’Emotion AI.

Ricerche di mercato

I team di marketing sono costantemente alla ricerca di metriche di performance fondamentali che segnalino il successo. Per la maggior parte dei team, la ricerca di mercato inizia nelle prime fasi di una campagna. Prendiamo ad esempio NeN, un’azienda energetica italiana. NeN aveva fatto un investimento a sei cifre per creare nuovi spot per una nuova campagna televisiva. Doveva però assicurarsi di utilizzare gli le campagne giuste, in grado di garantire il massimo livello di coinvolgimento e di ritorno per il brand. NeN ha quindi utilizzato l’Emotion AI per analizzare i livelli di attenzione e di coinvolgimento emotivo di ogni video, con lo scopo di selezionare quello più efficace.

Robotica

Il campo della robotica continua a evolversi, e l’Emotion AI ha introdotto un nuovo modo di sperimentare le interazioni uomo-robot. Un nuovo robot umanoide di nome Abel ha fatto notizia per le sue capacità empatiche. Grazie alla tecnologia di Emotion AI, Abel impara a migliorare le proprie capacità e le interazioni con le persone riconoscendo ed individuando le risposte emotive per reagire in modo appropriato.

Arte

L’Emotion AI ha anche il potenziale per sconvolgere l’industria dell’arte. Molti sostengono che l’arte equivale alle emozioni, oggi l’Emotion AI può catturare quali opere d’arte hanno il maggiore impatto emotivo. REASONEDArt, una startup di criptoarte, ha utilizzato una nuova metrica, chiamata Indice di Stendhal, per una delle sue recenti mostre, al fine di misurare le risposte emotive di ogni opera d’arte.

Automotive

L’Emotion AI può essere sfruttata dall’industria automobilistica in un modo leggermente diverso rispetto ai tre casi d’uso precedenti. In questo caso il suo utilizzo riguarda più che altro la sicurezza, misurando i livelli di attenzione e di risposta emotiva di chi guida e non può permettersi di distrarsi.

Salute

impatto significativo nel campo della sanità, poiché permette di aiutare i pazienti affetti da disturbi dello sviluppo neurologico e neurodegenerativi. Esiste anche un potenziale per aiutare comprendere i livelli di dolore in pazienti che non sono più in grado di comunicare.

Risorse umane

Un altro caso d’uso prevede l’utilizzo dell’Emotion AI per misurare i livelli di attenzione e coinvolgimento emotivo in differenti occasioni, come ad esempio durante la selezione del personale e corsi di formazione aziendali. In quest’ultimo caso i responsabili delle risorse umane possono capire quando alcune parti di una sessione di formazione sono confuse, in base alle reazioni dei dipendenti.

Perché l’Emotion AI è importante

L’Emotion AI, come indicato in precedenza, può fornire diversi benefici a seconda dei casi d’uso. Ma uno dei maggiori motivi per cui si dovrebbe decidere di utilizzare l’Emotion AI è il fatto che l’attenzione è limitata. Numerosi studi dimostrano che la popolazione di oggi si distrae facilmente, bastano solo tre secondi prima che qualcuno passi ad altro. L’economia dell’attenzione rende imperativo capire che cosa coinvolge il pubblico.

Un altro motivo per cui l’Emotion AI è importante è che permette di misurare ciò che altrimenti sarebbe intangibile. Sì, è possibile raccogliere i sentimenti di una persona attraverso un sondaggio, ma questo sarà ricco di bias per innumerevoli motivi. Ma come hanno sottolineato Ekman e molti altri, l’unica cosa che è impossibile negare e che le emozioni esistono in tutte le culture e che sono universali. Inoltre, l’Emotion AI apre le porte non solo a un processo decisionale più efficiente, ma anche alla previsione dei risultati futuri attraverso l’analisi predittiva.

Come iniziare ad usare l’Emotion AI

Iniziare ad utilizzare l’Emotion AI è semplice, soprattutto con uno strumento cloud come la piattaforma EmPower. Bastano pochi minuti per configurare un’analisi e circa 2 giorni per ottenere i risultati in una dashboard che mostrerà immediatamente tutti i KPI utili per prendere delle decisioni, come ad esempio il livello di attenzione e di coinvolgimento emotivo.

Scopri come funziona